Im Rahmen aktueller MÜ-Projekte evaluiere ich zur Zeit maschinelle Übersetzungsdienste und vergleiche Ansätze zur MÜ, um für unseren Kunden die beste Lösung auszuwählen, die der Markt aktuell zu bieten hat. Hierbei stoße ich unweigerlich immer wieder auf einen Begriff: ‚Neuronale maschinelle Übersetzung‘ (auch neural MT, NMT). Aber was genau hat es damit auf sich?

Ganz gleich welche Beiträge, Webinare, Interviews und Vorträge ich im Rahmen meiner Erhebungen zum neuen Mitspieler auf dem Feld maschineller Übersetzungsverfahren hinzuziehe – die Stimmen zur NMT zeichnen ein eindeutiges Bild: Das auf dem ‚deep learning‘ basierende Verfahren wird die Zukunft maschineller Übersetzungsverfahren erheblich mitprägen.

Tatsächlich ist es erstaunlich, was das Verfahren im Vergleich zu seinen Mitstreitern RBMT (regelbasierte MT) und SMT (statistische MT) innerhalb kürzester Zeit für Erfolge vorzuweisen hat. Die Ablösung für die mehr oder weniger stagnierende Entwicklung auf dem Gebiet der SMT in den letzten Jahren bahnte sich innerhalb von gut 2 Jahren den Weg aus zunächst vereinzelten wissenschaftlichen Publikationen in die reale Praxis maschineller Übersetzungsdienste.

Führende Anbieter von MÜ-Angeboten wie z. B. Microsoft Translator haben das Verfahren bereits in ihre Architekturen integriert (z.T. als Hybrid-Lösung zusammen mit SMT-Modellen) oder sind kurz vor dem Live-Gang.

Vielversprechende Ergebnisse

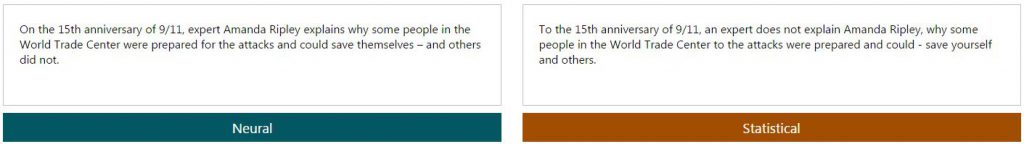

In vergleichenden Evaluationsstudien schneiden NMT-Systeme gegenüber ‚klassischen‘ RBMT- und SMT-Systemen erstaunlich gut ab. Der wohl deutlichste Unterschied besteht in der Lesbarkeit (Fluency) langer Sätze. Wo SMT-Verfahren auf Statistiken zu lokal begrenzten Phrasen innerhalb von Sätzen zurückgreifen müssen, kann der NMT-Ansatz auf Wort-Abhängigkeiten im kompletten Satz zurückgreifen und somit auch ‚long distance‘-Phänomene erfassen. Besonders interessant an dem Verfahren ist, dass grammatische Abhängigkeiten implizit (d.h. selbständig ohne die Voranlage von Suchanweisungen) gelernt werden. Ein NMT-System ist je nach Spezifikation somit in der Lage, die zugrundeliegende Phrasenstruktur des verarbeiteten Inputs zu lernen.

Ein direkter Vergleich der beiden Verfahren mit dem Microsoft Translator kann unter https://www.microsoft.com/de-de/translator/ vorgenommen werden.

Input (Beispielsatz): Zum 15. Jahrestag von 9/11 erklärt Expertin Amanda Ripley, wieso manche Menschen im World Trade Center auf die Anschläge vorbereitet waren und sich retten konnten – und andere nicht.

Das Verfahren

Neuronale MT basiert auf der Modellierung von neuronalen Netzen, die – in grob vereinfachter Form – dem neuronalen Aufbau des Gehirns nachempfunden sind. Die mit dieser Modellierung verbundenen Begrifflichkeiten wie RNN (Recurrent Neural Networks), Backpropagation und Attention Models wirken zunächst einmal abschreckend auf den potenziellen Nutzer, der sich i.d.R. aber nicht näher mit den Prozessen hinter dem Dienst beschäftigen muss.

Die Kernaspekte des neuronalen Ansatzes lassen sich gut im Vergleich mit der statistischen maschinellen Übersetzung herausstellen. Während in der SMT Wahrscheinlichkeiten für konkrete Wortformverbindungen ermittelt werden, sind in der NMT einzelne Wörter als Bündel von Informationen repräsentiert, die den Kontext des Wortes im kompletten Satz sowie eine Reihe weiterer grammatischer Eigenschaften abbilden. Diese Informationen werden als Input eines neuronalen Netzes verarbeitet (durch einen sog. Encoder) und über Zwischenschichten weiterer Neuronen (sog. hidden layers) vom sog. Decoder direkt in den zielsprachlichen Satz überführt. Die abstrakten Wortrepräsentationen ermöglichen zusammen mit unzähligen Verknüpfungen innerhalb der neuronalen Netze im Gegensatz zur SMT eine flexiblere Anpassung an neue Eingabesätze.

Diese Eigenschaften werden durch die Konfiguration sehr umfangreicher Modellparameter, einer Trainingsdauer bis zu mehreren Wochen und hohe Hardwareanforderungen erreicht.

Die Kinderkrankheiten

Trotz vielversprechender Ergebnisse stellt das größte Problem der NMT derzeit noch das begrenzte Vokabular dar, welches innerhalb der Modelle verarbeitet werden kann. Derzeit bewegt sich dieser Wert mit steigender Tendenz (auch in Abhängigkeit von der Hardware) zwischen 50.000 und 80.000 voneinander verschiedenen Wörtern (die Größe des Trainingstextes ist grundsätzlich nicht eingeschränkt). Zudem stellen Wörter mit sehr niedriger Auftretenshäufigkeit (rare words) ein Problem dar. Auch die lexikalische Wahl ist trotz weitgehend akkurater Übersetzungen und Satzlängen nicht immer korrekt.

Fazit

Von einem vollwertigen Ersatz für Humanübersetzungen ist die MT auch mithilfe neuronaler Netze noch ein gutes Stück entfernt. Da die Entwicklung auf dem Gebiet der NMT jedoch gerade erst anläuft, darf man gespannt sein auf neue Fortschritte, welche wohl nicht lange auf sich warten lassen werden.

Sie haben noch ein paar Unklarheiten oder Fragen zum Thema, dann kontaktieren Sie uns jederzeit! Wir beraten Sie gerne rund um das Thema maschinelle Übersetzung.