Das Interesse an maschineller Übersetzung (MÜ) war noch nie so groß wie heute, vor allem seit der Einführung der neuronalen maschinellen Übersetzung. Wir beobachten schon lange die Entwicklungen und technologischen Neuheiten und begleiten Projekte zur Einführung von MÜ. Einige Unternehmen entwickeln mittlerweile ihre eigenen Engines (z. B. Booking.com) oder binden auf ihre Domäne abgestimmte Engines in ihren bestehenden Übersetzungsworkflow ein.

Und auch immer mehr LSPs ziehen den Einsatz maschineller Übersetzung in Erwägung. Bei der großen Auswahl an Systemanbietern fällt die Entscheidung nicht leicht. Eine Qualitätsbewertung kann helfen. Wir geben einen kleinen Überblick über die Möglichkeiten der Bewertung von maschinellen Übersetzungsergebnissen und über das, was noch vor uns liegt.

Wofür braucht man überhaupt Qualitätsmetriken?

Szenario Nummer 1 ist die Auswahl des richtigen Systems. Ausschlaggebend für die Systemauswahl sind z. B. die benötigten Sprachkombinationen sowie das Fachgebiet, in dem die Ausgangstexte weitestgehend geschrieben sind und übersetzt werden müssen. Nicht jedes System ist bspw. für die Übersetzung von E-Commerce-Texten vom Russischen ins Chinesische prädestiniert.

Szenario Nummer 2 ist die Qualitätsbewertung, nachdem man sich für ein System entschieden hat. Dann nämlich geht es ans Training und die stetige Verbesserung (Tuning) der sogenannten Engines.

Automatische oder humane Bewertung?

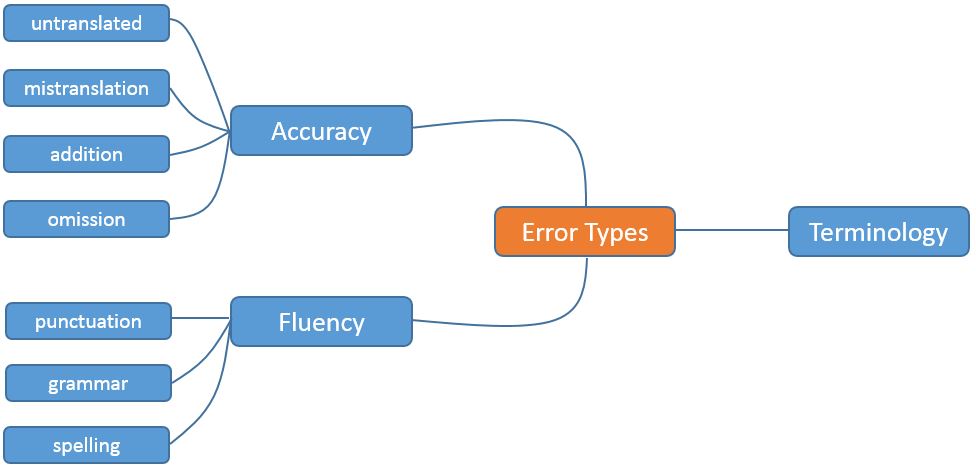

Für die Bewertung der Übersetzungsergebnisse können automatische Verfahren angewendet werden, die mithilfe von Algorithmen den maschinell erstellten Zieltext mit einer professionellen, manuell erstellten Referenzübersetzung abgleichen. Je ähnlicher sich die beiden sind, desto besser das Ergebnis. Diese Methoden sind besonders in der Entwicklung eines MÜ-Systems oder während der Trainingsphase sinnvoll, denn die Scores geben schnell Aufschluss darüber, ob das System sich verbessert oder verschlechtert hat. Die humane Bewertung ist zwar kosten- und zeitintensiver als die automatische, liefert jedoch detaillierte und wertvolle Ergebnisse, die auch Auskunft über den Grad der Domänenadaption (stilistische und inhaltliche Anpassung an ein Wissensgebiet) geben. Standardmetriken wie z. B. das MQM-Framework sollen dafür sorgen, dass die Ergebnisse nicht allzu subjektiv ausfallen. Idealerweise bewertet dann ein Muttersprachler den Zieltext anhand dieser vorher festgelegten Kriterien.

Welche Metrik für welches System?

Maschinelle Übersetzungssysteme können auf unterschiedlichen Ansätzen basieren. Heute unterscheiden wir zwischen regelbasierter, statistischer und neuronaler maschineller Übersetzung. Für die Bewertung von statistischer maschineller Übersetzung (SMÜ) wurde eigens eine statistische Qualitätsmetrik entwickelt: BLEU (Bilingual Evaluation Understudy). Bis heute erfreut sie sich großer Beliebtheit und wird nicht nur für SMÜ eingesetzt. Aktuell wird die neuronale maschinelle Übersetzung (NMÜ) ebenfalls anhand von BLEU-Scores bewertet. Aufgrund der unterschiedlichen Funktionsweise (mehr dazu in unserem Blog „Neuronale maschinelle Übersetzung – Mysterium?„) ist der BLEU-Score hier jedoch nur bedingt aussagekräftig, weshalb die Humanevaluation, insbesondere bei der NMÜ, vor die Systemauswahl geschaltet werden sollte.

Wie geht es weiter?

Wir haben uns bereits im Blog „Gesucht: neue Metriken für die Neuronale MÜ“ Gedanken zur Bewertung von NMÜ gemacht und in der Zwischenzeit haben sich diverse Unternehmen dem Problem angenommen. So hat bspw. der LSP One Hour Translation einen Humanevaluierungsservice namens ONEs (OHT NMT Evaluation Score) entwickelt, bei dem viele Humanübersetzer sehr schnell anhand einer Auswahl von Strings Feedback zu der Qualität des NMÜ-Outputs geben. Sie betrachten Satz für Satz und bewerten ihre Qualität. So können verschiedene NMÜ-Systeme (momentan Google, Microsoft, Amazon, deepL, Systran, Baidu, Promt, IBM Watson, Globalese und Yandex) und verschiedene Sprachkombinationen miteinander verglichen werden. Der Datenaustausch erfolgt über eine API.

Egal ob RBMÜ, SMÜ oder NMÜ, es empfiehlt sich immer, ein menschliches Auge auf den maschinellen Output zu werfen und sich nicht blind auf einen automatisch errechneten Score zu verlassen. Methoden wie ONEs sind ein erster Schritt zur sinnvollen und aussagekräftigen Bewertung von NMÜ-Systemen.