Natural Language Processing, kurz „NLP“, bedeutet so viel wie „maschinelle Verarbeitung natürlicher Sprache“. Sie ermöglicht unter anderem die Interaktion zwischen Mensch und Maschine (Stichwort: Sprachassistenten). Wir bei blc haben täglich mit Anfragen zu diesen Themen zu tun. Aber wo wird NLP überall eingesetzt und wie funktionieren diese Technologien grundsätzlich? Das lesen Sie in meinem Blog.

Wie geht NLP?

Mithilfe von Algorithmen entschlüsseln Computer das gesprochene oder geschriebene Wort und können so die inhaltliche Bedeutung „verstehen“ und darauf sogar reagieren. Das kann die Ausführung von Anweisungen sein („Spiele Britney Spears!“), die Beantwortung einer Frage („Wie ist das Wetter heute?“) oder die Übersetzung oder Extraktion eines Textes sein. Dabei wird Text durch die NLP-Prozesse in strukturierte Daten umgewandelt, um diese dann maschinell verarbeiten zu können.

Neben NLP sollten zwei weitere Akronyme erwähnt und erklärt werden, die für den Gesamtprozess von großer Bedeutung sind:

NLU

Das Kürzel NLU steht für Natural Language Understanding und ist eine Unterkategorie des NLP, bei der es um eine viel engere, aber ebenso wichtige Facette des Umgangs mit unstrukturierten Daten geht. Mithilfe von NLU-Techniken werden unstrukturierte Daten in strukturierte Formen umgewandelt, die eine Maschine verstehen und auf die sie reagieren kann.

NLG

NLG bedeutet Natural Language Generation. So wird der Vorgang genannt, wenn ein Computer Sprache erzeugt. Hier werden strukturierte Daten in Text umgewandelt.

NLP steckt hinter vielen Anwendungen, die wir tagtäglich nutzen

Chatbots und Sprachassistenten

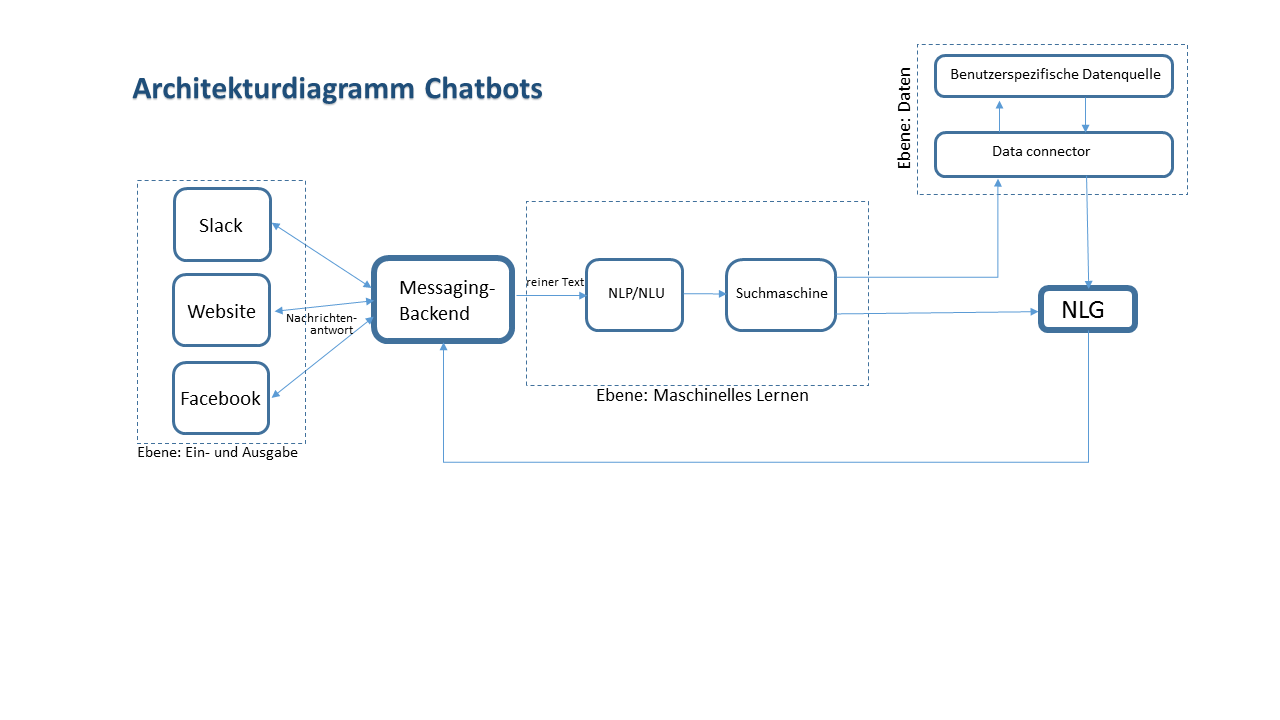

Chatbots arbeiten wie eine Help Desk-Software, es sind nur keine Menschen, die die Fragen beantworten. Der Nutzer gibt seine Frage in ein Chatfenster ein und der Chatbot ist im besten Fall in der Lage, die passende Antwort zu finden. Manche Chatbots können nur Fragen beantworten, auf die sie vorbereitet wurden. Andere sind „intelligenter“ und können auch weniger spezifische Fragen verstehen, da sie die Beziehungen zwischen Begriffen herstellen können. KI-Chatbots (wobei KI für Künstliche Intelligenz steht) sind darüber hinaus in der Lage, aus jeder Interaktion zu lernen und ihren Arbeitsumfang weiter zu entwickeln.

Sprachassistenten wie Siri oder Ihr Bordcomputer im Auto können in der Regel ausschließlich Anfragen bearbeiten, auf die sie zuvor programmiert wurden. Mit dem Internet verbundene Assistenten können darüber hinaus noch „Wissen“ aus der Cloud abrufen. Wenn z.B. Alexa eine Frage gestellt oder sie zu etwas aufgefordert wird, schickt sie eine Aufnahme der Stimme zu einem Server in einem riesigen Rechenzentrum. Der Server analysiert die Audioaufnahme, berechnet eine passende Aktion und teilt Alexa mit, wie sie reagieren soll. Das alles muss natürlich blitzschnell passieren und erfordert große Rechenleistung und schnelle Datenleitungen.

Speech-to-Speech

Bei der Speech-to-Speech Übersetzung wird während eines Dialogs zwischen zwei Menschen in Echtzeit übersetzt. Bei dieser Technik wird ein Sprachsignal in eine Quellsprache übertragen, die anschließend in der Zielsprache ausgegeben wird. Mithilfe dieser Technologie können Menschen miteinander sprechen oder chatten, die nicht dieselbe Sprache beherrschen. Bei der EAMT 2018 in Alicante konnte ich die Pilots von Waverly Labs selbst ausprobieren.

Die kleinen „Piloten“ werden wie Kopfhörer ins Ohr gesteckt. Über Bluetooth sind sie mit dem Smartphone verbunden, auf dem die dazugehörige App installiert ist. Die gesprochene Sprache wird transkribiert und von einer neuronalen Übersetzungsengine in die Sprache des Gesprächspartners übersetzt. Dieser kann die Übersetzung nun auf seinem Display lesen und gleichzeitig auch über den Knopf im Ohr hören.

Maschinelle Übersetzung

Auch die maschinelle Übersetzung setzt natürlich NLP ein um den eingegebenen Text zu analysieren. So werden bei der neuronalen maschinellen Übersetzung (NMÜ) Spracheinheiten in sog. Vektoren umgewandelt, deren Bedeutung und Beziehungen zueinander ermittelt und diese dann in die gewünschte Zielsprache übertragen werden.

Text aus eingescannten Dokumenten extrahieren

Eingescannte Dokumente gelten als unstrukturierte Daten. Mit speziellen Tools wie bspw. Tesseract OCR oder Ocropus kann Text aus einem Scan extrahiert und in ein strukturiertes Format gebracht werden. Für die Extraktion des rohen Texts nutzen diese Tools OCR (Optical Character Recognition). Die extrahierten Texte benötigen meist noch eine Nachbearbeitung. Die Tools können aber auch mit eigenen Daten trainiert werden, sodass sie sich von Mal zu Mal verbessern.

Sie versteht mich einfach nicht!

Wer hat nicht schon einmal folgende Antwort seines Sprachassistenten gehört: „Ich habe leider nicht verstanden“. Haben Sie daraufhin eine andere Formulierung ausprobiert, bis das Gerät die gewünschte Antwort gegeben hat? Die menschliche Sprache und Ausdrucksweise ist für eine Maschine oft nicht klar und deutlich genug. Emotionen, Stimmung, Sarkasmus, Ironie und Dialekte erschweren die Kommunikation mit dem Computer. Daher ist sie aktuell noch auf wenige Anweisungen reduziert, die sich oft wiederholen und die häufig gebraucht werden.

Sprache ist überall. Wir nutzen sie auf vielen Geräten und auf viele verschiedene Arten und Weisen. Hinter der maschinellen Verarbeitung unserer Eingaben steckt aber immer das Natural Language Processing.

Vor allem Chatbots sagt man eine glorreiche Zukunft im Kundensupport und Marketing voraus. Schon jetzt merken Benutzer oft nicht, dass am anderen Ende kein Mensch, sondern ein Roboter arbeitet. Mithilfe der neuronalen künstlichen Intelligenz sind Chatbots schon heute in der Lage verblüffend menschlich zu formulieren und sogar Witze zu machen.