„Wie, Du hast noch nichts von ChatGPT gehört? Wie geht das denn?“

So ähnlich dürften viele Erstanwender der Demo-Version von ChatGPT reagieren, wenn sie auf Menschen treffen, die noch keinen Kontakt mit der Technologie von OpenAI hatten. Die darauffolgenden Beschreibungen der Fähigkeiten des Bots führen dann in der Tat fast ausnahmslos zu erstaunten Gesichtern und kaum jemand bleibt von diesem speziellen KI-Erleuchtungsmoment unberührt.

Das Erstaunen ist nicht unbegründet, denn tatsächlich ist ChatGPT in der Lage, Aufgaben in einer Detailtiefe zu erfüllen, die bisherigen Sprachmodellen vorbehalten waren. Beispiele dieser Aufgaben sind:

- Zusammenfassung von Fachtexten im Stil eines bestimmten Autors

- Erzeugung von Geschichten und Gedichten

- Erstellung von Programmcode zu natürlichsprachlichen Beschreibungen einer Softwarefunktionalität

- Rezeptvorschläge anhand einer Zutatenliste

Diese und viele weitere Anwendungsfälle mit ChatGPT durchzuspielen, macht ungemein Spaß und lässt einen ahnen, was da in Zukunft noch kommt. Genau dieser Aha-Moment ist es, der jedoch auch flächendeckend zu falschen Einschätzungen der Fähigkeiten und Einsatzszenarien des Bots führt. Wir wollen in diesem Blog mit diesen Fehleinschätzungen aufräumen und etwas Licht auf die Möglichkeiten und Einschränkungen des Bots werfen.

ChatGPT – Deep Dive zum Deep Learning

Wer die Evolution der Sprachmodelle und Chatbots in den letzten Jahren verfolgt hat, dem ist auch der Fall von Googles LaMDA (Language Model for Dialogue Applications) bekannt. Der Chatbot hatte im Juni 2022 Schlagzeilen gemacht, als der Software-Ingenieur Blake Lemoine mit Chatverläufen an die Öffentlichkeit ging, die belegen sollten, dass der Chatbot ein Bewusstsein erlangt hatte.

Auch wenn sich die Mehrheit der Fachwelt einig ist, dass es sich bei den Aussagen des Bots nicht um den Ausdruck eines Bewusstseins handelt, so war das Modell doch zumindest in der Lage, den Turing-Test zu bestehen, d.h. es war in der Lage, gegenüber einem Menschen überzeugend als menschlicher Gesprächspartner aufzutreten.

Man darf annehmen, dass diese Überzeugungskraft mit immer besseren Sprachmodellen nur noch zunimmt. Menschen werden in vielen Einsatzszenarien nicht mehr in der Lage sein, eine KI als solche zu identifizieren (außer durch sehr gezielte Fragen, die auf die KI-Mensch-Unterscheidung abzielen). Diese mehr und mehr verschwindende Unterscheidungsgrenze zwischen Menschen und Maschine birgt jedoch auch die größten Fallstricke und Gefahren beim Einsatz der KI: Wir schreiben der KI aufgrund ihres menschlichen Ausdrucksvermögens UND ihres technischen Ursprungs Eigenschaften zu, die sie gar nicht, oder nur teilweise besitzt.

Die falschen Grundannahmen, die bei der Verwendung oft mitschwingen, sind folgende:

In der öffentlichen Erprobungsphase war ChatGPT 3.5 bisher ein statisches Model, d.h. die Daten (und Fakten) mit denen es trainiert wurde, haben potenziell ein Verfallsdatum. Die Trainingsdaten des Modells reichten in der Version 3.5 bis einschließlich 2021 und umfassen Softwaredokumentationen, Programmcode und diverse Quellen aus dem Bereich „Internetphänomene“. Es ist also gut möglich, dass ChatGPT zu spezifischen Inhalten, die nicht Teil des Trainings waren, keine oder inkorrekte Aussagen treffen kann.

Mit der Integration in Microsoft Bing hat sich die Situation grundlegend geändert. Da das System als Erweiterung der Suchmaschinenfunktionalität nun Anschluss an aktuelle und aktualisierte Daten aus dem Internet hat, kann das Modell diese nutzen, um Suchergebnisse und Aufgaben auf Basis aktualisierter Daten zurückzugeben und zusammenzufassen. Ob und inwieweit diese Echtzeitdaten genutzt werden, um das Modell selbst fortlaufend zu optimieren, ist aktuell nicht herauszufinden. Man kann jedoch sicher davon ausgehen, dass das User-Feedback (wie bisher auch schon) eine wichtige Quelle für Optimierungen des Bots ist.

Die Korrektheit von Aussagen des Bots kann NICHT garantiert werden. Dies hat zwei mögliche Gründe:

- Entweder verfügt der Bot nicht über eine entsprechende Faktenbasis (da die Daten nicht im Training oder in einem Suchergebnis enthalten waren)

- Der Bot hat eine entsprechende Faktenbasis, gibt diese aber unzureichend oder falsch wieder

Belege für dieses Verhalten haben die Chatbot-Demonstrationen von Microsoft (ChatGPT) und Google (LambDA/Bard) unlängst selbst angeboten:

Obwohl das Modell Zugang zu den korrekten Fakten in den Beispielen hat, war es nicht in der Lage, die korrekten Antworten zu geben. Dieses Verhalten hängt damit zusammen, dass das Model Fakten nicht wie eine statische Datenbank behandelt, sondern Informationen als Teil seiner neuronalen Netzarchitektur behandelt, womit wir bei Punkt 3 angelangt sind:

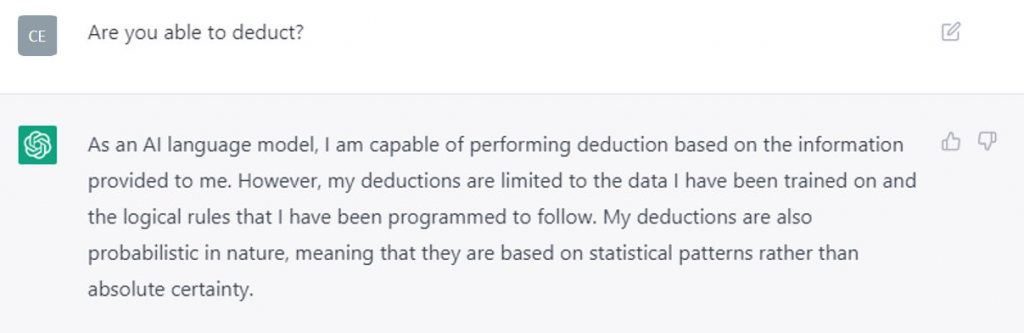

Die Antworten des Bots legen oftmals nahe, dass er ein tiefes Verständnis der Sachzusammenhänge in den Daten besitzt. Tatsächlich ist das sogenannte „Reasoning“ – die Fähigkeit, deduktive und induktive Schlussfolgerungen zu ziehen sowie Vorhersagen auf Basis einer Datenlagen zu machen – eine der erstaunlichsten Eigenschaften großer Sprachmodelle. Solche Sprachmodelle basieren auf neuronalen Methoden/Deep Learning, funktionieren also ähnlich wie ein menschliches Gehirn. Sie sind bis zu einem gewissen Grad in der Lage, aufgrund der verarbeiteten Daten Zusammenhänge zwischen Objekteigenschaften zu erkennen und Generalisierungen vorzunehmen – und dies lediglich auf Basis der präsentierten Daten und der in ihnen enthaltenen sprachlichen Konzepte.

Hier ein Beispiel: Wenn ChatGPT nach der Definition von Mug gefragt wird, gibt er folgende Antwort:

„A mug is a cylindrical-shaped cup with a handle, typically used for drinking hot beverages like coffee, tea, or hot chocolate. Mugs can be made from a variety of materials, including ceramic, glass, plastic, and metal, and can come in a wide range of sizes, shapes, and designs. They often have a capacity of around 8 to 12 fluid ounces (240 to 350 milliliters), but larger and smaller sizes are also available. Mugs can have various features like lids, insulated walls, and decorative patterns or prints.“

Anhand der Beschreibung ist jedoch nicht abzulesen, inwieweit die Beschreibung das Resultat einer gelernten Abstraktion über dem Konzept „Becher“ ist, oder ob der Bot sich hier lediglich an feststehenden, existierenden Definitionen eines Bechers in den Trainingsdaten bedient. Per Google Suche konnte exakt diese Beschreibung zumindest nicht gefunden werden. Auch der Teilsatz „A mug is a cylindrical-shaped cup with a handle“ kann so nicht gefunden werden, wohingegen der Satz „A mug is a cup with a handle“ häufig zu finden ist. ChatGPT hat die Objekteigenschaft „cylindrical shaped“, also möglicherweise als Generalisierung selbst aus den Trainingsdaten abgeleitet.

Der Feststellung dieser Fähigkeiten widmen sich mittlerweile etliche Forschungsarbeiten. So erstaunlich diese Modellfähigkeiten auch sind, so klar ist auch gleichzeitig: Ein wirkliches Verständnis im Sinne eines menschlichen Subjekts ist hier nicht vorhanden. Lediglich die wohlgeformte Präsentation linguistischer Symbole erzeugt zusammen mit unseren Assoziationen und Projektionen die Illusion eines denkenden Subjekts. Einen großen Teil zu dieser Illusion trägt der Optimierungsprozess von ChatGPT bei, der auf Reinforcement Learning from Human Feedback (RLHF) basiert. Zur Erzeugung von möglichst menschlichen und spezifischen Aussagen des Bots wurde das System nämlich mithilfe von sehr vielen menschlichen Mitarbeitern fortlaufend bewertet.

Antworten des Bots wurden mit einem Bewertungssystem in erwünschte und weniger erwünschte Antworten eingeordnet. Anhand dieses Feedbacks hat der Bot gelernt die gewünschte Aussageform für spezifische Sachverhalte zu erzeugen. Auch weiterhin wird das in Interaktionen gewonnene Feedback der Nutzer eine wichtige Quelle der Systemoptimierung darstellen.

Fazit

Es haben sich bereits viele Anwendungsbereiche abgezeichnet, in denen ChatGPT oder ChatGPT-ähnliche Systeme ganze Arbeitsfelder revolutionieren können. Hierzu zählt nicht zuletzt die Softwareentwicklung. Aber auch die Lehre und der kreative Sektor wird den Einfluss der Modelle spüren: Überall dort, wo Texte zusammengefasst oder erzeugt werden sollen, ohne auf immer gleiche Textbausteine zurückzugreifen, werden Sprachmodelle früher oder später ihren Einzug finden. Bei allen Möglichkeiten (und Gefahren) sollten wir jedoch nicht vergessen, dass die Modelle eben keine generelle KI darstellen, die zu eigenständigem Denken oder gar einem Bewusstsein in der Lage ist.

ChatGPT fasst seine Fähigkeiten auf die Frage nach seiner Deduktionsfähigkeit treffend wie folgt zusammen:

Würde man den Bot also lediglich mit Daten aus Fantasy-Romanen füttern, in denen uns unbekannte Naturgesetze vorherrschen, würde der Bot diese genauso lernen und wiedergeben, wie die naturwissenschaftlichen Zusammenhänge, die er aus seinen nicht-fiktionalen Trainingsdaten erhält. Trotz der wirklich erstaunlichen Leistungen des Bots ist es noch ein langer Weg, bis das System die Korrektheit seiner eigenen Aussagen evaluieren kann, ganz zu schweigen von der Faktenbasis. Hier ist er genauso auf das Vertrauen in seine Trainingstexte angewiesen, wie ein menschlicher Nutzer von Wikipedia. Oder können Sie immer zweifelsfrei feststellen, ob einem:einer Autor:in in Wikipedia ein Fehler unterlaufen ist?

Wissen Sie, was ChatGPT mit Terminologie zu tun hat?

In unserem Webinar am 23.02.2023 um 10 Uhr verraten wir Ihnen dieses Geheimnis.

Hier geht es zur Anmeldung!